目次

近年、AIによる動画や音声生成技術は、本物とフェイクの判別がつかないほど目覚ましい進化をとげています。

AIによる動画生成では、2022年3月にネット上に投稿された、ウクライナのゼレンスキー大統領のディープフェイク動画が話題になりました。

この時は、ゼレンスキー氏とは異なる声や不自然な動きがあったことから、すぐにフェイク動画であることが判明しました。

ですが最近では、特定の人物の声を複製する音声クローニングと呼ばれる技術が急速に発達しており、たった2~3秒の音声データがあれば、一致率85%のクローン音声を生成できるというのです。

ディープフェイク動画や音声クローニング技術が発達すればするほど、懸念されるのは犯罪へ悪用されることです。

すでにAI技術を悪用した犯罪は世界各地で起こっており、中でもクローン音声を悪用したAI音声詐欺の被害が発生しています。

そこでこの記事では、AI音声詐欺で考えられる詐欺事例や、AI音声詐欺の対策など、AI音声詐欺について詳しく解説していきます。

AI音声詐欺とは

AI音声詐欺とは、人工知能(AI)で特定の人物の声を合成する音声クローニングを悪用した詐欺のことです。

米コンピュータセキュリティ企業のマカフィーが発表したAI音声詐欺に関する調査結果によりますと、たった2~3秒の音声データがあれば、一致率85%のクローン化した音声データを生成することができるというのです。

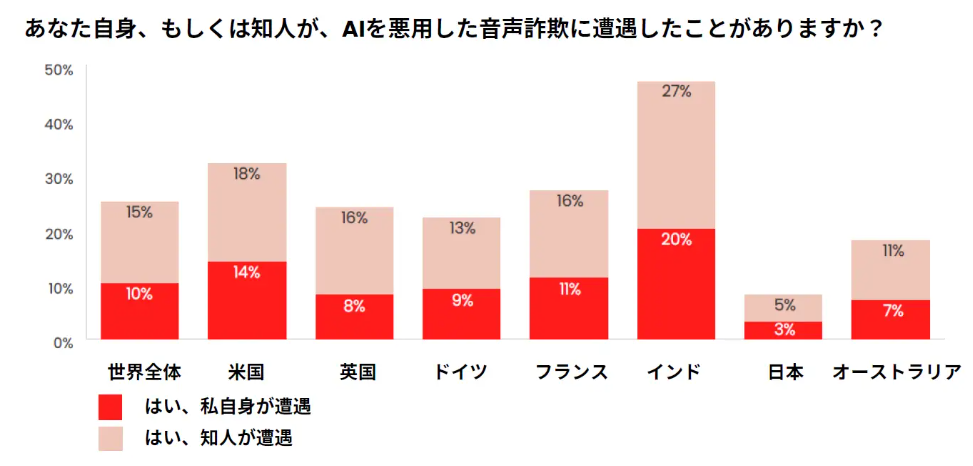

同社が7か国の18歳以上の成人7,054人を対象に、AIを悪用した音声詐欺に関する調査を行ったところ、AIによる音声クローニングを使った詐欺はすでに世界中で発生しているものの、日本における音声詐欺の遭遇率は、世界7か国で最も低く、世界平均の約3分の1でした。

(出典:PR TIMES)

しかしこの結果は、「日本は音声詐欺の被害に遭遇する可能性が低い」ことを表しているわけではありません。

AI音声詐欺は、英語圏からはじまり、少し遅れて日本に上陸すると考えられるからです。

AI音声詐欺が日本に上陸した際には、手口や事例が広まっていない日本では、急速かつ甚大な被害が発生すると考えれるため、非常に注意が必要です。

音声データの入手方法とは

音声データの入手方法は主に二つあると考えられます。

- SNS上にアップロードされている動画から入手する方法

- 間違い電話を装い電話をかけ、音声を録音する方法

では、それぞれ見ていきましょう。

SNS上の動画から入手する方法

AI音声詐欺において特に注意が必要なのは、SNS上にアップロードされている動画などから音声データを抜き取られることです。

今はX(前Twitter)やInstagramといったSNSなどで、日常の写真や動画、自撮り画像などを何気なくアップする方も多いでしょう。

ですが、この行動は非常に危険で、文章だけでも過去の投稿などから個人情報が特定できてしまう場合もありますが、そのうえでさらに顔や声がわかるような動画を投稿していた場合には、AI音声詐欺に悪用される可能性が考えられます。

そのため、人物が写った動画や音声が入った動画を不特定多数の人が見られるプラットフォームに投稿しないなど、細心の注意を払うようにして下さい。

間違い電話を装って音声データを入手する方法

間違い電話を装い電話をかけ、「もしもし」など相手が話した声を録音し、音声データとして入手する方法です。

間違い電話を装った電話で音声データを録音される方法は、メジャーな手口になる可能性は低いかもしれませんが、決して可能性は0ではありません。

特殊詐欺の被害は、知らない電話番号からの着信から始まることが多くあります。

様々な詐欺被害から身を守るためにも、身に覚えのない番号、知らない番号からの電話には出ないよう、くれぐれもご注意ください。

AI音声を悪用した詐欺で考えられる手口とは

AI音声を悪用した犯罪では、いったいどんな手口が考えられるのでしょうか。

すでに世界で発生しているAI音声詐欺の事例をもとに、手口を解説してきます。

バーチャル誘拐による身代金詐欺

バーチャル誘拐とは、誘拐をでっちあげ、AIで生成したクローン音声で身代金を要求することです。

バーチャル誘拐はすでにアメリカで発生しており、発信元不明の電話に出たところ、娘の声で「ママ助けて!」と泣き叫ぶ声が聞こえた後、男の声で「身代金を払え」と要求されたといいます。

その後、娘は自分の部屋にいることが確認されたため、誘拐が嘘であったことが発覚したということですが、今後も同様の手口は増えていくと考えられます。

SNS上に子供の動画をアップすると、こうした詐欺のターゲットにされてしまうかもしれませんので、くれぐれもご注意ください。

AI音声を悪用したオレオレ詐欺

オレオレ詐欺や振り込め詐欺といった特殊詐欺の被害が後を絶たない要因のひとつに、近年の特殊詐欺の実行犯らが手にしている名簿には、家族の名前はもちろん、家族の勤め先や貯蓄額など、実に詳細な情報が記載されていることがあげられます。

そのような状況で、”声”まで成りすまされてしまった場合、騙されてしまう可能性が高まることは容易に想像がつくでしょう。

オレオレ詐欺の被害が少ないアメリカでも、AIで生成されたクローン音声によるオレオレ詐欺の被害は急増しており、2022年の被害額は1100万ドル(約15億円)にも上っているということです。

日本でも、今後はAIで生成されたクローン音声を使ったオレオレ詐欺の手口が広がると考えられるため、最大限の注意をするようにしてください。

有名人になりすました投資詐欺

近年、芸能人や著名人などの名前や画像を無断使用した投資関連の広告にアクセスしたことがきっかけで投資詐欺の被害に遭う事例が世界中で発生しており、甚大な被害をもたらしています。

現時点でも、有名人になりすました”偽の投資広告”による投資詐欺被害は非常に深刻な状況ですが、さらにクローン化された有名人の声を使って投資へ勧誘する手口が広まった場合、今以上に被害が拡大することが考えられます。

InstagramやFacebookなどのSNS上に掲載されている投資関連の広告は、ほとんど詐欺業者によって投稿されているものであると考えられるため、騙されないようくれぐれもご注意ください。

SNS上に掲載されている詐欺広告については、こちらの記事で詳しく解説していますので、あわせてご参照ください。

AI音声詐欺を防ぐための対策

では、AI音声詐欺を防ぐためにはどうしたらよいのでしょうか。

そこで、簡単にできるAI音声詐欺の対策を解説します。

家族間で合言葉を設定する

AI音声詐欺を防ぐため、家族間で合言葉を設定しましょう。

AIによる音声クローニングでは、本人そっくりの声を生成することができるため、声だけで判別することが困難になります。

そのため、子供や孫、家族や友人たちで合言葉を決めておき、助けやお金を求める連絡が来た際に、必ず合言葉を聞くようにしましょう。

知らない電話番号からの電話には出ない

AI音声詐欺を防ぐため、知らない電話番号からの電話に出ないことを徹底しましょう。

AI音声詐欺をはじめとする特殊詐欺は、知らない番号からかかってくる一本の電話をきっかけに、詐欺被害に巻き込まれるケースが非常に多いです。

そのため、様々な詐欺被害から身を守るためにも、知らない番号からの電話には出ないことを徹底してください。

万が一、知らない番号からの電話に出てしまった際、家族の声で「携帯が壊れた」「事件に巻き込まれた」「強盗にあった」などと言われた場合は一度電話を切り、こちらから家族に直接電話するなど、必ず確認するようにしてください。

音声データを共有する際は慎重に

AI音声詐欺を防ぐため、SNSに音声データを投稿する際は慎重に行いましょう。

音声クローニングは、ほんの数秒の音声データで複製することができてしまいます。

また、AI音声詐欺に使用する音声データは、TwitterやInstagramなどのSNSで標的を見つけることが多く、詐欺師は個人情報が多く公開されているSNSアカウントを見つけると、対象者について徹底的に調べあげ、詐欺のターゲットとします。

そのため、不特定多数の人がSNSアカウントを見ることができる状態で、SNSで子供の動画や写真を投稿してる方や、自身の写真や動画を投稿することは非常に危険です。

SNSへの投稿は犯罪に巻き込まれるリスクがあることを知ったうえで、慎重に行うようにしてください。

AI音声詐欺には要注意

AI技術は、人々の暮らしを豊かに、便利にしてくれる一方で、犯罪に利用されると甚大な被害が発生するリスクがあります。

技術の発展により、詐欺の手口も巧妙化して騙されやすくなると感じられるかもしれませんが、基本的な詐欺の対策を取っておくだけで、被害に遭う可能性をグッと減らすことができます。

- 家族や友人間で合言葉を設定しておく

- 知らない番号からの電話に出ない

- 家族の声で助けを求められた場合は、こちらから本人に確認する

- その場で家族に連絡が取れない場合は警察に相談する

AI音声詐欺による特殊詐欺は、日本で急増することが考えられますので、ご家族や友人など、大切な人に事例を共有してください。

この記事が、AI音声詐欺の被害を防ぐ一助になることを願っています。